前段时间增加了建站二级域名,原来博客站的主域名不带www,把主域调整为www.xiuzhanwang.com之后,需要做几个重要修改,否则权重就会分散,降低网站权重。分享血的教训,让新站长少走弯路。

本博客刚开始的时候主域是xiuzhanwang.com,但很多带www的页面被收录,不想让百度再抓取这些页面,如何删除呢?这让秀站网秀站网相当烦恼。

重复收录页面的原因

1.动态内容已被抓取

百度蜘蛛会根据页面的链接情况爬取并放出快照,如页面内容调整或者删除了,快照就较难删除。

常见的有:

/tag.php?/%CF%D6%B4%FA%BC%F2%D4%BC/ (tag标签)

/plus/list.php?tid=3 (dede动态列表)

/plus/list.php?tid=85&zxfg=%CF%D6%B4%FA%BC%F2%D4%BC等 (dede筛选)

有的朋友说把那些页面设置为404就好,参考文章《网页404页面制作及注意事项》但是已经被删除的静态页面还好,动态页面就没办法。建议新手采用静态页面的方式学习SEO。

2.仍存在相对路径

相对路径形式

/web/ (目录)

/seo/ (目录)

/images/logo.png

/css/style.css

绝对路径形式

http://www.xiuzhanwang.com/web/ (目录)

http://www.xiuzhanwang.com/seo/ (目录)

http://www.xiuzhanwang.com/images/logo.png (文件)

http://www.xiuzhanwang.com/css/style.css (文件)

www.xiuzhanwang.com的实际上是二级域名(和m.xiuzhanwang.com是同等的权重),如果两个域名都被抓取了,并且URL是相对路径,百度蜘蛛会在两个域名下重复抓取,放出的快照是有一些www,一些又没有www。建议URL路径采用绝对路径的方式,即使被收录了,久而久之也会慢慢的恢复,只是时间比较长。设置方法参考文章《什么是URL绝对路径和相对路径SEO优化重要环节》

3.突然改变主要域名

原主域名xiuzhanwang.com 修改为www.xiuzhanwang.com

90%以上的新网站都没做好301,不然为什么还有这么网站需要优化呢?301原来用得比较多的是换域名,现在做网站SEO游湖是不可能找个新域名,地球人都知道老域名相对更容易些。

中途才做的301,旧快照消失经常持续几个月不等,很明显感觉排名受影响。百度蜘蛛经常对正常优化方法有延后性,但是对黑帽的却响应及时得很…改变域名的影响参考文章《避免更换域名或改版带来的损失降到最小》

4.中途才设置伪静态

搜索引擎确实对静态页面有青睐,但每次都要生成,如果虚拟空间支持.htaccess的就能做伪静态,形式如:

动态:

http://www.xiuzhanwang.com/plus/list.php?tid=1

伪静态:

http://www.xiuzhanwang.com/list-1.html

秀站网已经写了很多关于伪静态的文章了,点击查看伪静态设置,一般伪静态是后面进阶优化的时候才做的,一般SEOer接手的网站都是较差的…这样的情况解决起来比较棘手。

5.自带的临时三级域名被收录

每个购买的空间都有一个临时域名,其实被抓取临时域名这样的情况还是比较多见,所以在刚开始建站的时候用robots屏蔽全站,建设好了才让蜘蛛抓取,解决的办法只能是301。参考文章《什么是robots协议对seo的影响》

6.网站多次改版

一个网站刚开始的时候都会进行或多或少的调整,包括结构调整和内容调整等,有很多死链产生。拿到手的网站都比较差的原因,死马当活马医的情况还是比较多,除非网站有上千个被收录,这时死链比较影响权重。

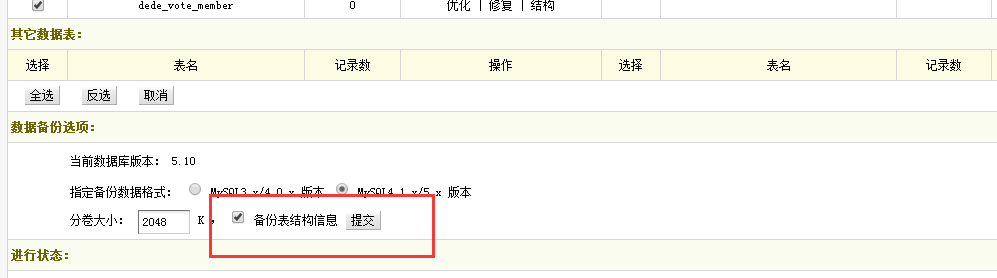

一些情况较差的网站就可以调整后重新生成网站地图,向百度提交死链。设置方法:网站地图sitemap,如果是有规律的话可以提交网站改版,写好改版规则即可,最终完成全部改版时间也是1-3个月不等。

删除重复收录的百度快照方法

1.闭站保护

找了很多网上资源,由于站内写了比较多的.htaccess规则,比较麻烦,还是选择百度工具的“闭站保护”功能,有朋友误解为能删除这些快照,其实这些快照不被人看到而已,还是存在索引。当然而且又一定的时间限制。

把不想被抓取的域名申请闭站保护,一般都会通过,也不需要让页面返回404,会在2小时左右闭站成功。

2.全部链接换成绝对路径

不管被抓取的页面如何,如果里面的路径都是主要域名的路径,权重也不会分散到哪里,蜘蛛就不会重复爬取页面。

3.加大更新高质量原创文章

在做了必要的301重定向和绝对路径修改之后,百度会进一步考察新域名的情况,这个时候一定要加大高质量的文章内容,这样新域名和老域名的情况就有不同,蜘蛛会积极爬取,久而久之百度就停止老域名的抓取。

4.对已被搜索引擎抓取的页面处理

静态页面直接向百度提交404就好, 针对某些动态页面,比如搜索页面、问答页面等,这些如果被抓取了很有可能会影响我们网站的关键词库,方法有很多:

①声明该页面不建立索引,在源代码</head>之前加

<meta name="robots" content="noindex">

②robots声明不允许抓取;

③在页面的<title><keywords><description>不调用任何搜索词,动态搜索页面是不那么容易被删除的,前段时间还有万网搜索让黑客注入大量的垃圾信息,造成SEO排名下降,就是调用了这些搜索词;

剩下的就是等搜索引擎进一步处理了,这时候应该多更新高质量内容吸引蜘蛛来爬取页面。